Con il Regolamento (UE) 2024/1689 del 13 giugno 2024 giunge a compimento il documento europeo sull’intelligenza artificiale (IA), concordato con gli stati membri nel dicembre del 2023 e approvato dal Parlamento il 13 marzo 2024. È un documento che ha modificato una serie di norme europee precedenti[1], è stato pubblicato in Gazzetta Ufficiale Europea il 12 luglio scorso ed entrerà in vigore dal prossimo 2 agosto, trovando applicazione a partire dal 2 agosto 2026.

Il percorso dell’AI ACT UE

Il Regolamento “EU AI Act”[2] è il documento europeo più importante in materia di IA con l’intento di rendere l’UE “leader mondiale nello sviluppo di un’IA sicura, affidabile ed etica”, garantendo “la tutela dei principi etici”[3].

Sono questi i presupposti di atti precedentemente elaborati dal Consiglio europeo (riunione straordinaria del Consiglio europeo 1 e 2 ottobre 2020 – Conclusioni, EUCO 13/20, 2020) e dal Parlamento europeo, con la “Risoluzione del Parlamento europeo del 20 ottobre 2020 recante raccomandazioni alla Commissione concernenti il quadro relativo agli aspetti etici dell’intelligenza artificiale, della robotica e delle tecnologie correlate (2020/2012[INL])”.

La proposta di regolamento è stata presentata dalla Commissione Europea il 21 aprile 2021, con l’obiettivo di creare un quadro normativo armonizzato e proporzionato per l’IA nell’Unione Europea. L’iter legislativo è stato lungo, ma l’approvazione della legge è stata pressoché plebiscitaria, con 523 voti a favore, 46 contrari e 49 astenuti.

Scopi del Regolamento UE sull’AI

Il documento europeo introduce un quadro normativo e giuridico comune che abbraccia tutti i settori (ad eccezione di quello militare) e tutti i tipi di intelligenza artificiali (non solo quella generativa). L’obiettivo prioritario è garantire che l’IA sia sviluppata e utilizzata in modo sicuro, responsabile ed etico, in linea con i valori dell’Unione europea. Il Regolamento, invero, “garantisce la libera circolazione transfrontaliera di beni e servizi basati sull’IA, impedendo così agli Stati membri di imporre restrizioni allo sviluppo, alla commercializzazione e all’uso di sistemi di IA”[4], salvo espressa autorizzazione del disciplinamento stesso. Si tratta di una regolamentazione che è parte della strategia digitale europea, tesa a rafforzare la sovranità digitale dell’UE e a stabilire standard che possano rendere l’Europa adatta all’era digitale[5], con una chiara attenzione ai dati, alla tecnologia e alle infrastrutture. In questa prospettiva, si rende necessario che i Paesi dell’UE rafforzino le proprie azioni, con investimenti adeguati in competenze digitali, connettività di alta qualità e con l’adozione dell’IA. La consapevolezza di fondo è nel ritenere l’IA in grado di apportare benefici alle persone, migliorando servizi e ambiti produttivi, nonché, al contempo, agevolando la protezione delle persone fisiche, delle imprese, della democrazia e dello Stato di diritto, oltre che la protezione dell’ambiente, promuovendo l’innovazione e l’occupazione e rendendo l’Unione un leader nell’adozione di un’IA affidabile.

L’intelligenza artificiale nell’AI Act

Il Regolamento (UE) 2024/1689 definisce l’IA in termini di “famiglia di tecnologie in rapida evoluzione che contribuisce al conseguimento di un’ampia gamma di benefici a livello economico, ambientale e sociale nell’intero spettro delle attività industriali e sociali”[6]. Il sistema dell’AI, pertanto, comprende differenti strumenti che possono garantire “un miglioramento delle previsioni, l’ottimizzazione delle operazioni e dell’assegnazione delle risorse e la personalizzazione delle soluzioni digitali disponibili per i singoli e le organizzazioni”[7], fornendo rilevanti vantaggi competitivi alle imprese e conducendo a risultati vantaggiosi sul piano sia sociale, sia ambientale. Numerosi, infatti, sono i campi di applicazione: in materia di assistenza sanitaria; in agricoltura e per la sicurezza alimentare; nella gestione delle infrastrutture e dei servizi pubblici; per i trasporti e la logistica; per l’efficienza dal punto di vista energetico e delle risorse; nel monitoraggio ambientale e nella conservazione e ripristino della biodiversità e degli ecosistemi; per la mitigazione dei cambiamenti climatici e adattamento ad essi; nei campi dei media, dello sport, della cultura, della sicurezza e della giustizia e nell’ambito dell’ istruzione e formazione. Il prerequisito dell’IA, secondo l’approccio UE, si sostanzia nell’essere una tecnologia antropocentrica, ovvero deve “fungere da strumento per le persone, con il fine ultimo di migliorare il benessere degli esseri umani”[8]. Nel contesto dell’applicazione del regolamento, l’alfabetizzazione in materia di IA dovrebbe fornire a tutti i cosiddetti “pertinenti attori della catena” il valore dell’IA e le conoscenze necessarie, per garantire l’adeguata conformità e la sua corretta esecuzione[9].

Struttura del Regolamento EU AI Act

Il documento è corposo, composto da:

- una serie di “considerando” (ben 180), attraverso i quali è tracciata l’impostazione complessiva dell’UE rispetto all’IA e tra i quali particolarmente rilevante è il Considerando n. 27, che elenca i sette principi etici elaborati nel 2019 dall’AI HLEG indipendente nominato dalla Commissione. Si tratta di principi etici tesi a garantire che l’IA sia affidabile ed eticamente valida e che comprendono: intervento e sorveglianza umani, robustezza tecnica e sicurezza, vita privata e governance dei dati, trasparenza, diversità, non discriminazione ed equità, benessere sociale e ambientale e responsabilità;

- 113 articoli, raggruppati in tredici capi, relativi a disposizioni generali (artt. 1-4), pratiche di IA vietate (art. 5), sistemi di IA ad alto rischio (artt. 6-49), obblighi di trasparenza per i fornitori e i deployer di determinati sistemi di IA (art. 50), misure a modelli di IA per finalità generali (artt. 51-56), sostegno dell’innovazione (artt. 57-63), governance (artt. 64-70), banca dati dell’UE per i sistemi di IA ad alto rischio (art. 71), monitoraggio successivo all’immissione sul mercato, condivisione delle informazioni e vigilanza del mercato (artt. 72-94), codici di condotta e orientamenti (artt. 95-96), delega di potere e procedura di comitato (artt. 97-98), sanzioni (artt. 99-101), disposizioni finali (artt. 102-113);

- 13 allegati strettamente collegati a specifici articoli del Regolamento.

AI act: obblighi differenti per diversi livelli di rischio

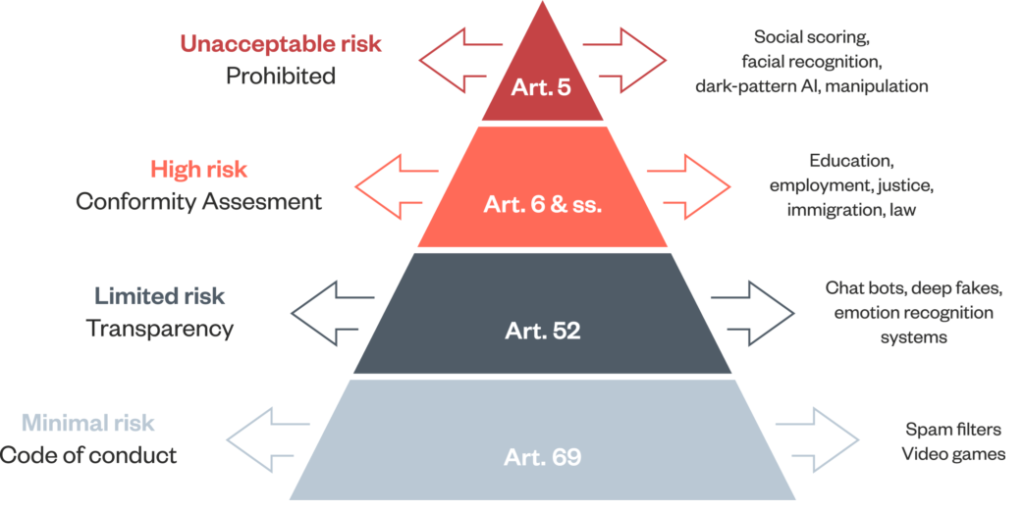

L’AI Act stabilisce obblighi per l’IA sulla base dei possibili rischi e del livello d’impatto. Nel documento si distinguono quattro categorie di rischio, a seconda del loro potenziale impatto sui cittadini: rischio inaccettabile, rischio alto, rischio limitato e rischio minimo.

https://www.adalovelaceinstitute.org/resource/eu-ai-act-explainer

Il rischio inaccettabile riguarda i sistemi dell’IA che contraddicono i valori dell’UE, rappresentano una minaccia per le persone e che, pertanto, sono vietati. Proprio per questo i divieti, nonché le disposizioni generali del Regolamento UE Ai Act dovrebbero applicarsi già a decorrere dal 2 febbraio 2025. Tra i divieti emergono, in particolare:

- la manipolazione cognitivo-comportamentale di persone o gruppi vulnerabili specifici (ad es. giocattoli attivati vocalmente che incoraggiano comportamenti pericolosi nei bambini);

- il punteggio sociale, in base al quale le persone vengono classificate del tenendo conto del comportamento, dello stato socioeconomico o delle caratteristiche personali;

- l’identificazione biometrica e categorizzazione delle persone;

- i sistemi di identificazione biometrica in tempo reale e a distanza, come il riconoscimento facciale.

Vengono considerati sistemi dell’IA a rischio alto quelli che possono avere un impatto significativo, in termini negativi, sui diritti fondamentali e sulla sicurezza delle persone. Essi vengono suddivisi in due categorie: sistemi di intelligenza artificiale utilizzati in prodotti che rientrano nella legislazione sulla sicurezza dei prodotti dell’UE (es: giocattoli, aviazione, automobili, dispositivi medici e ascensori); sistemi di intelligenza artificiale che rientrano in aree specifiche e dovranno essere registrate in una banca dati dell’UE (es. istruzione e formazione professionale; occupazione, gestione dei lavoratori e accesso al lavoro autonomo, gestione delle migrazioni, dell’asilo e del controllo delle frontiere, etc.). Tutti i sistemi di IA ad alto rischio dovranno essere valutati sia prima di essere immessi sul mercato, sia durante tutto il loro ciclo di vita. Gli utenti avranno anche il diritto di presentare reclami sui sistemi di IA alle autorità nazionali designate.

I sistemi a rischio limitato possono influenzare i diritti o le volontà delle persone, ma in misura minore rispetto a quelli ad alto rischio. Sono, invece, considerati a rischio minimo quei sistemi dell’IA che non hanno alcun impatto diretto sui diritti fondamentali o sulla sicurezza delle persone e che offrono ampi margini di scelta e controllo da parte di chi ne fruisce.

I requisiti della “trasparenza”

La trasparenza, assieme all’accuratezza e all’affidabilità, è uno dei requisiti fondamentali richiesti dall’UE ai sistemi dell’IA, “per evitare impatti negativi, mantenere la fiducia dei cittadini e garantire la responsabilità e mezzi di ricorso efficaci”[10], oltre che “per garantire il rispetto dei diritti fondamentali delle persone interessate, in particolare i loro diritti alla libera circolazione, alla non discriminazione, alla protezione della vita privata e dei dati personali, alla protezione internazionale e alla buona amministrazione”[11]. L’accezione “trasparenza” sottintende che i sistemi dell’IA “sono sviluppati e utilizzati in modo da consentire un’adeguata tracciabilità e spiegabilità, rendendo gli esseri umani consapevoli del fatto di comunicare o interagire con un sistema di IA e informando debitamente i deployer delle capacità e dei limiti di tale sistema di IA e le persone interessate dei loro diritti”[12]. Ciò suppone che i fornitori di sistemi di IA dovranno redigere un’adeguata documentazione relativa alla valutazione prima di immettere un sistema sul mercato o di attivarlo, fornendo tale documentazione, su richiesta, alle autorità nazionali competenti. Spetterà ad ogni fornitore registrare il sistema di IA nella banca dati dell’UE istituita a norma del Regolamento UE AI Act. In particolare, per aumentare la trasparenza sui dati utilizzati nelle fasi di pre-addestramento e addestramento dei modelli di IA per finalità generali, compresi testo e dati protetti dalla normativa sul diritto d’autore, si rende necessario che i relativi fornitori elaborino sintesi sufficientemente dettagliate dei contenuti utilizzati per l’addestramento del modello di IA per finalità generali, da mettere a disposizione degli utenti. Inoltre, l’adempimento dell’obbligo di trasparenza non va interpretato come ostacola al diritto alla libertà di espressione e al diritto alla libertà delle arti e delle scienze garantito dalla Carta, in modo particolare quando il contenuto fa parte di un’opera o di un programma manifestamente creativo, satirico, artistico, fittizio, o analogo fatte salve le tutele adeguate per i diritti e le libertà dei terzi[13].

Un’innovazione da sostenere adeguatamente

L’IA è ormai sempre più preponderante nella nostra vita quotidiana e documenti come l’AI Act europeo ne garantiscono una diffusione centrata su principi fondamentali, che non ne limitano l’implementazione, pur regolamentandone tutti quegli aspetti che possono incidere negativamente sulle persone, a vari livelli. L’UE mira a sostenere un’adeguata innovazione dei sistemi dell’IA, affinché essi siano effettivamente al servizio di tutti cittadini. È necessario, pertanto, che vi sia una crescente consapevolezza delle potenzialità positive dei sistemi dell’IA. Ciò presuppone una profonda conoscenza dell’IA, da approcciare con spirito critico. In quest’ottica, è importante promuovere un’istruzione e una formazione digitali di alta qualità, consentendo a discenti ed insegnanti in primis di acquisire e condividere le competenze e le abilità digitali necessarie, compresa l’alfabetizzazione mediatica e il pensiero critico, per riuscire a partecipare attivamente all’economia, alla società e ai processi democratici[14] e a sostenere, conseguentemente, la continua innovazione dei sistemi dell’IA per un futuro imprevedibile, ma che non può non fondarsi sulla capacità umana di governare in maniera adeguata, ovvero etica, ciò che è il prodotto della sua creatività al servizio stesso dell’umanità.

[1] Regolamento (UE) 2024/1689 del Parlamento europeo e del Consiglio, del 13 giugno 2024, che stabilisce regole armonizzate sull’intelligenza artificiale e modifica una serie di regolamenti (CE): n. 300/2008, (UE) n. 167/2013, (UE) n. 168/2013, (UE) 2018/858, (UE) 2018/1139 e (UE) 2019/2144 e le direttive 2014/90/UE, (UE) 2016/797 e (UE) 2020/1828 (regolamento sull’intelligenza artificiale). Testo rilevante ai fini del SEE.

[2] EU AI Act: l’uso dell’intelligenza artificiale nell’UE è stato disciplinato dalla legge AI, che rappresenta la prima legge globale al mondo in materia.

[3] Regolamento (UE) 2024/1689 del Parlamento europeo e del Consiglio, del 13 giugno 2024, op. cit., p. 2.

[4] Op.cit., p. 1.

[5] Per orientare la trasformazione digitale dell’UE, la Commissione europea ha presentato il programma strategico del Decennio digitale europeo, che contiene obiettivi e traguardi concreti per il 2030 in diversi settori relativi a competenze, infrastrutture digitali sicure e sostenibili, trasformazione digitale delle imprese e digitalizzazione dei servizi pubblici.

[6] Regolamento (UE) 2024/1689 del Parlamento europeo e del Consiglio, del 13 giugno 2024, op. cit., p. 2.

[7] Ibidem.

[8] Ibidem.

[9] Cfr. Regolamento (UE) 2024/1689 del Parlamento europeo e del Consiglio, del 13 giugno 2024, op. cit., p. 6.

[10] Regolamento (UE) 2024/1689 del Parlamento europeo e del Consiglio, del 13 giugno 2024, op. cit., p. 17.

[11] Ibidem.

[12] Regolamento (UE) 2024/1689 del Parlamento europeo e del Consiglio, del 13 giugno 2024, op. cit., p. 8.

[13] Cfr. Regolamento (UE) 2024/1689 del Parlamento europeo e del Consiglio, del 13 giugno 2024, op. cit.

[14] Cfr. ibidem.